本地部署解压直接运行 无广告纯绿色

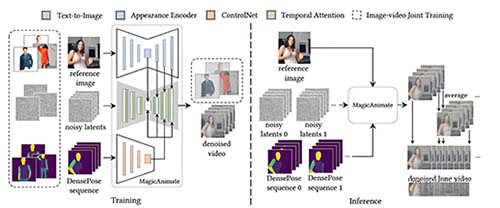

基于扩散模型的人像动画生成框架

MagicAnimate是由新加坡国立大学(NUS)与字节跳动联合研发的开源AI框架,专注于通过扩散模型技术将静态人物图像转换为符合指定运动轨迹的动态视频,同时保持人物外观的高度一致性与动作的自然流畅性。

核心功能与技术特点:

- 时间一致性动画:采用视频扩散模型,结合时空注意力机制,确保动画在连续帧间保持高度一致性,避免跳帧或抖动,呈现自然流畅的运动效果。

- 外观编码器:通过精细的外观特征提取与保持技术,确保动画中人物的身份特征(如面部、服装)在不同帧间稳定不变。

- 跨身份与跨领域动画:支持利用不同视频中的运动序列驱动目标人物动画,甚至能处理油画、电影角色等非现实领域图像,实现如跑步、瑜伽等多样化动作。

- 多人动画支持:可同步处理多个人物的指定动作,适用于复杂场景下的群体动画生成。

- 与T2I模型结合:可与DALL-E 3、Stable Diffusion等文本到图像生成模型协同工作,实现从文本描述到动态视频的一键生成。

应用场景:

- 动画与影视制作:快速生成高质量角色动画,提升制作效率。

- 游戏开发:增强NPC(非玩家角色)动作的自然度与表现力。

- 虚拟现实(VR)/增强现实(AR):创建沉浸式交互体验,提升用户参与感。

- 社交媒体与娱乐:制作个性化3D头像、动态表情包,丰富内容创作形式。

- 广告与品牌营销:生成生动的品牌形象动画,增强广告吸引力。

- 元宇宙与虚拟偶像:推动虚拟角色的实时交互与表现,拓展元宇宙应用场景。

技术实现与优势:

- 基于深度学习与计算机视觉技术,整合卷积神经网络(CNN)、时序卷积网络(TCN)等先进算法,实现精准的动作识别与特征提取。

- 采用光流算法与动作迁移技术,生成平滑的运动轨迹,确保动画的真实感与连贯性。

- 通过生成对抗网络(GAN)实现图像风格迁移与中间帧生成,填补关键帧间隙,优化动画过渡效果。

用户体验与社区支持:

- 提供简洁直观的用户界面与实时预览功能,支持关键帧动画、骨骼绑定等多样化编辑工具,降低动画制作门槛。

- 项目已开源,并配备Gradio在线演示与Discord社区支持,便于开发者快速上手与问题反馈。

云计算与数据安全:

- 利用分布式计算架构与弹性伸缩技术,确保高效稳定的计算服务。

- 严格的数据加密与访问控制机制,保障用户数据的安全性与隐私性。

MagicAnimate凭借其强大的技术实力与广泛的应用潜力,正逐步成为动画制作、游戏开发、虚拟现实等领域的重要工具,推动相关行业的创新与发展。